ai 多模态驱动,ocs全光交换方案迎来新风口-九游会旧版

光纤在线编辑部 2024-01-09 15:10:50 文章来源:原文转载

导读:人工智能(ai)和机器学习(ml)技术的蓬勃发展,对于高性能计算(hpc)和大规模数据处理的需求不断攀升。当前gpu互联端口已迅速升级至800g(2x400g),并预计下一代将演进到1.6t(2x800g),使得数据中心对光互联的带宽需求愈发紧迫。

1/09/2024,光纤在线讯,人工智能(ai)和机器学习(ml)技术的蓬勃发展,对于高性能计算(hpc)和大规模数据处理的需求不断攀升。当前gpu互联端口已迅速升级至800g(2x400g),并预计下一代将演进到1.6t(2x800g),使得数据中心对光互联的带宽需求愈发紧迫。

al/ml集群互联

hpc和数据中心互联面临新挑战

随着ai/ml集群规模的迅速增长,从几百张加速卡扩展至上万张,集群互联距离也从数十米延伸至上百米。这导致对低功耗和低延迟的需求变得尤为紧迫,而传统的电子交换面临着瓶颈。同时,hpc也面临着更高的要求,包括集群规模的灵活配置和网络的长期稳定运行。大规模数据中心互联也面临spine交换机性能瓶颈和端口速率演进的挑战,随着速率提升,200g及以上速率单纯依赖硬件升级能效提升不明显,需要通过架构重构等方式进一步提升能效,降低运营成本。

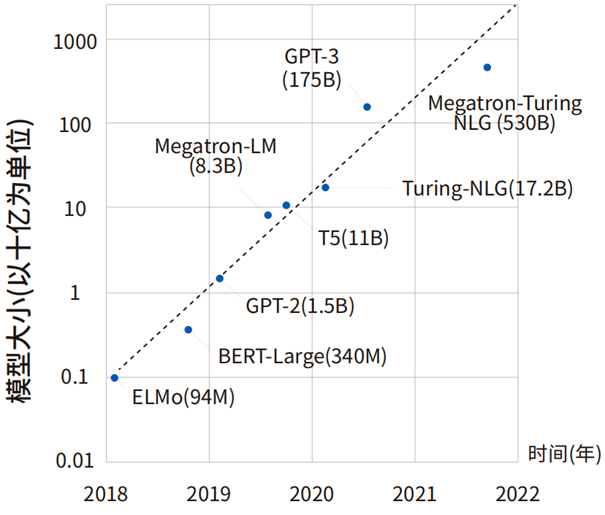

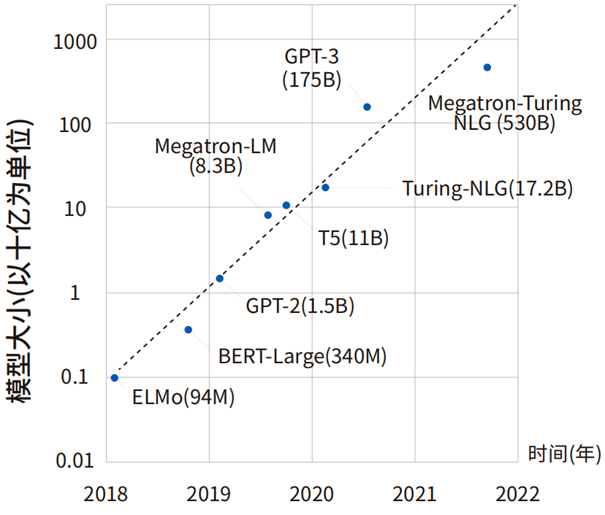

ai模型规模的演进

支持软件定义网络(sdn)

全光交换方案应运而生

为解决这些挑战,全光交换(ocs)方案应运而生。ocs通过其全光交换的优势,实现光信号的透明传输、支持光纤中任意速率/调制格式/通信波长光信号的交换,并具有无时钟抖动、无延迟、不读取数据、无泄漏风险等特点。此外,ocs还支持软件定义网络(sdn)使能控制,提高了系统的灵活性。

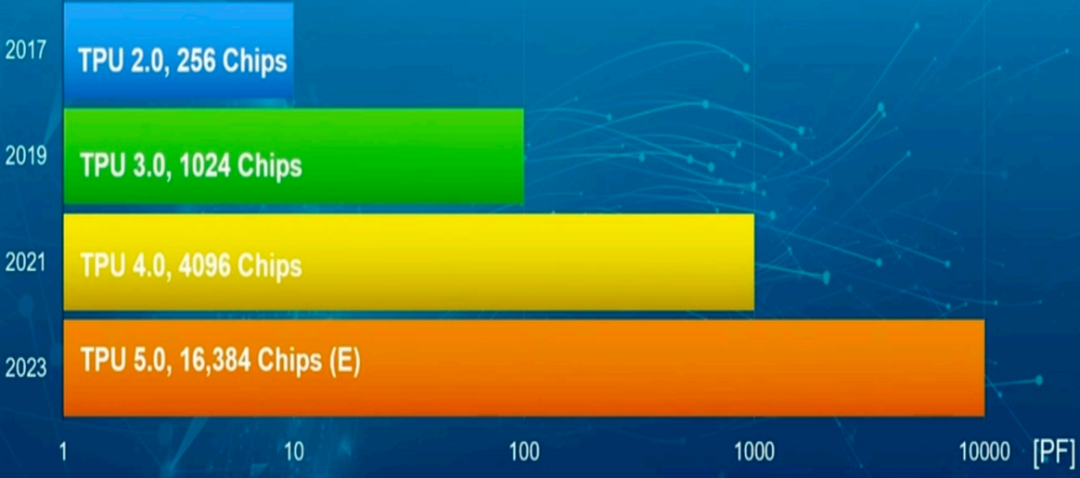

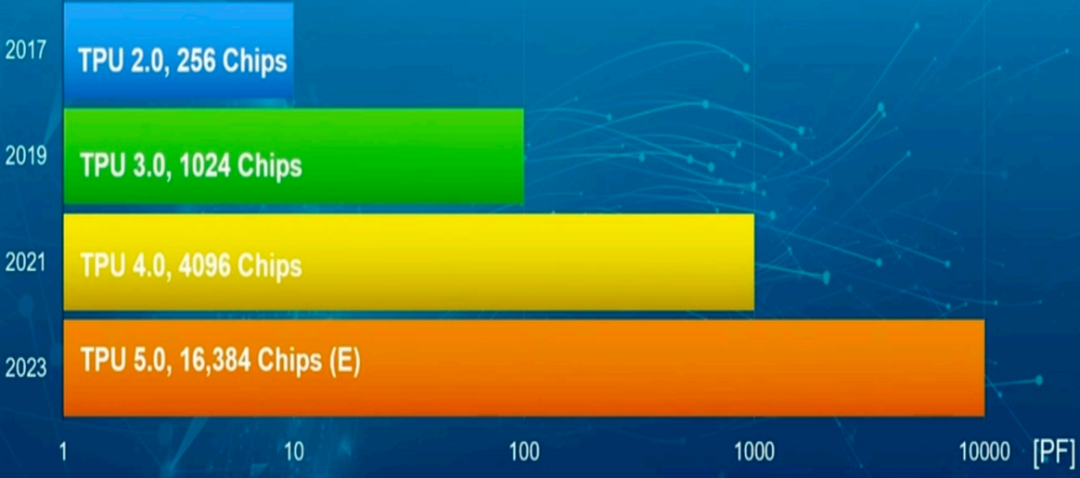

ocs全光交换方案已成功应用于一些领先的数据中心,就在去年12月6日google推出的人工智能模型gemini,其配套硬件tpuv5版本,加强了ocs光交换技术的应用。在google tpuv4的应用中,ocs显著提升了集群互联的可靠性,即使在主机可靠性下降到99.0%的情况下,仍能保证tpu切片有出色的性能,系统整体性能提升超过6倍以上。

google tpu集群规模演变

ai算力“军备竞赛”

ocs九游会旧版的解决方案应用广阔

软件定义全光交换通过其在高性能计算和数据中心应用中的卓越性能,为ai网络的发展提供了重要支持。随着数据中心的演进,ocs全光交换技术将在光互联领域展现更为广泛的应用前景,为数字化转型的成功注入新的活力。aigc大模型时代必然导致算力军备竞赛,推动算力芯片和网络升级,有望促进行业长期增长。

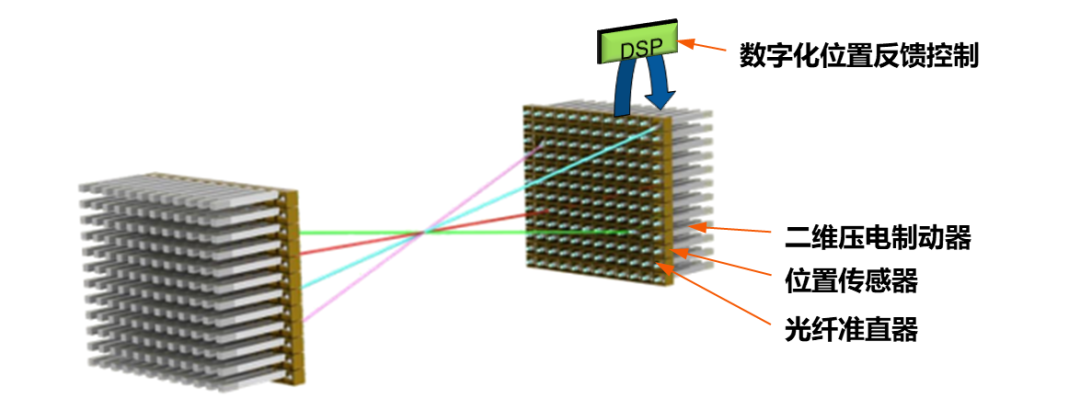

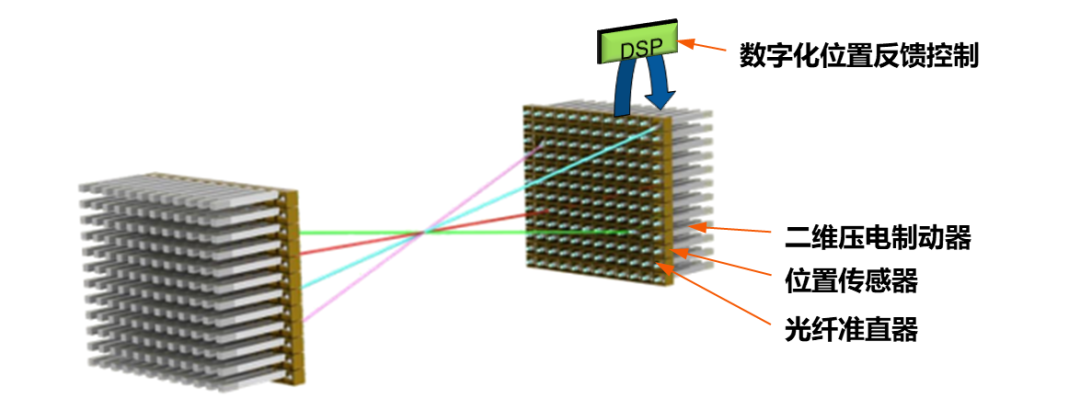

智算数据中心对光互联的带宽需求越来越高,随着集群规模的扩大,将需要更大的端口ocs,同时需提升ocs可靠性和插回损性能。而基于directlight直接光束偏转技术的ocs九游会旧版的解决方案,具有超低损耗和回损,高抗震性等优异性能,在运营成本、吞吐量、功耗和成本方面都取得重大收益。基于directlight的ocs方案可以轻松实现可靠的远程选择性路由、在线性能监控和自动保护等,除了智算中心应用,在卫星互联网,量子互联网等方向也有广泛应用,ocs将成为6g时代空天地一体化网络重要组成部分。

directlight技术原理

凌云光大矩阵全光交换九游会旧版的解决方案

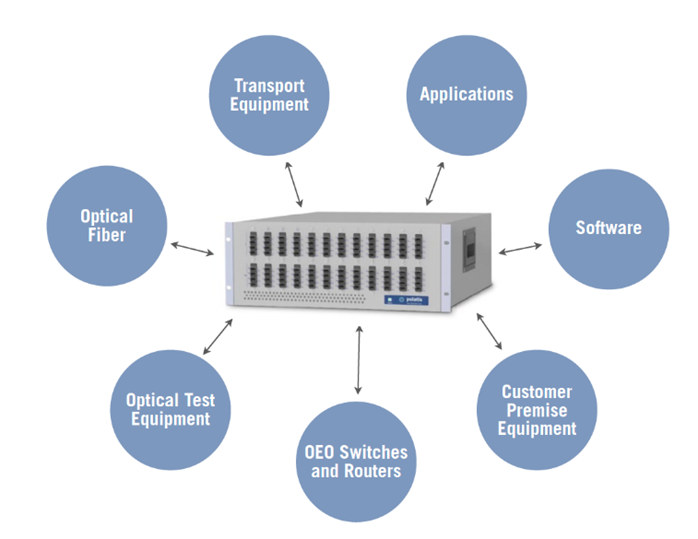

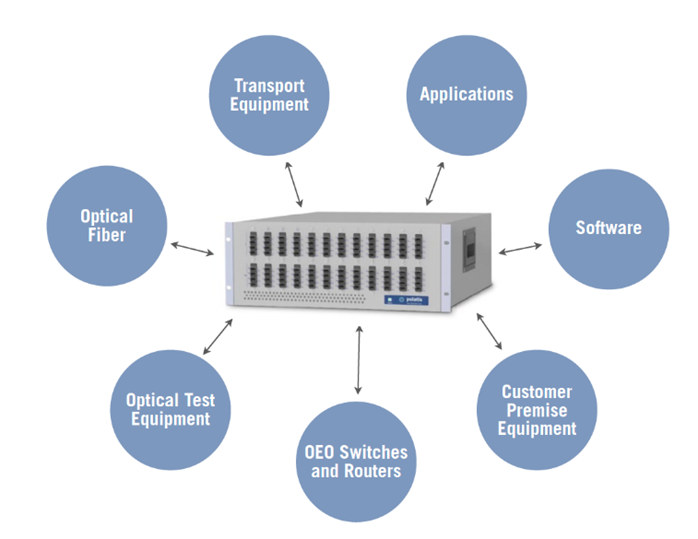

凌云光自2001年起即关注光交换技术、产品与应用的推广,2015年正式与全球光交换厂家h s polatis公司建立战略九游会官网登录入口网页的合作伙伴关系,共同开创光交换应用的新时代。h s polatis 提供低损耗的全光交换九游会旧版的解决方案,用于远程光纤层配置、保护、监控、重新配置和测试。

h s polatis 6000/7000系列全光交换机性能卓越,支持完全无阻塞8×8~576×576矩阵规模,具有极佳的抗震性,支持宇航级应用。超低插回损,光学指标优异,支持单路双向传输和暗光纤交换,全光透明传输,与速率/协议无关,支持400g/800g及以上速率平滑升级,可选n×n对称以及任意端口配置结构(cc系列),满足sdn应用。可以广泛的应用在ai智算中心全光交换、卫星互联网、量子互联网和产线自动化测试等应用场景。

h s polatis 6000/7000系列全光交换机

al/ml集群互联

hpc和数据中心互联面临新挑战

随着ai/ml集群规模的迅速增长,从几百张加速卡扩展至上万张,集群互联距离也从数十米延伸至上百米。这导致对低功耗和低延迟的需求变得尤为紧迫,而传统的电子交换面临着瓶颈。同时,hpc也面临着更高的要求,包括集群规模的灵活配置和网络的长期稳定运行。大规模数据中心互联也面临spine交换机性能瓶颈和端口速率演进的挑战,随着速率提升,200g及以上速率单纯依赖硬件升级能效提升不明显,需要通过架构重构等方式进一步提升能效,降低运营成本。

ai模型规模的演进

支持软件定义网络(sdn)

全光交换方案应运而生

为解决这些挑战,全光交换(ocs)方案应运而生。ocs通过其全光交换的优势,实现光信号的透明传输、支持光纤中任意速率/调制格式/通信波长光信号的交换,并具有无时钟抖动、无延迟、不读取数据、无泄漏风险等特点。此外,ocs还支持软件定义网络(sdn)使能控制,提高了系统的灵活性。

ocs全光交换方案已成功应用于一些领先的数据中心,就在去年12月6日google推出的人工智能模型gemini,其配套硬件tpuv5版本,加强了ocs光交换技术的应用。在google tpuv4的应用中,ocs显著提升了集群互联的可靠性,即使在主机可靠性下降到99.0%的情况下,仍能保证tpu切片有出色的性能,系统整体性能提升超过6倍以上。

google tpu集群规模演变

ai算力“军备竞赛”

ocs九游会旧版的解决方案应用广阔

软件定义全光交换通过其在高性能计算和数据中心应用中的卓越性能,为ai网络的发展提供了重要支持。随着数据中心的演进,ocs全光交换技术将在光互联领域展现更为广泛的应用前景,为数字化转型的成功注入新的活力。aigc大模型时代必然导致算力军备竞赛,推动算力芯片和网络升级,有望促进行业长期增长。

智算数据中心对光互联的带宽需求越来越高,随着集群规模的扩大,将需要更大的端口ocs,同时需提升ocs可靠性和插回损性能。而基于directlight直接光束偏转技术的ocs九游会旧版的解决方案,具有超低损耗和回损,高抗震性等优异性能,在运营成本、吞吐量、功耗和成本方面都取得重大收益。基于directlight的ocs方案可以轻松实现可靠的远程选择性路由、在线性能监控和自动保护等,除了智算中心应用,在卫星互联网,量子互联网等方向也有广泛应用,ocs将成为6g时代空天地一体化网络重要组成部分。

directlight技术原理

凌云光大矩阵全光交换九游会旧版的解决方案

凌云光自2001年起即关注光交换技术、产品与应用的推广,2015年正式与全球光交换厂家h s polatis公司建立战略九游会官网登录入口网页的合作伙伴关系,共同开创光交换应用的新时代。h s polatis 提供低损耗的全光交换九游会旧版的解决方案,用于远程光纤层配置、保护、监控、重新配置和测试。

h s polatis 6000/7000系列全光交换机性能卓越,支持完全无阻塞8×8~576×576矩阵规模,具有极佳的抗震性,支持宇航级应用。超低插回损,光学指标优异,支持单路双向传输和暗光纤交换,全光透明传输,与速率/协议无关,支持400g/800g及以上速率平滑升级,可选n×n对称以及任意端口配置结构(cc系列),满足sdn应用。可以广泛的应用在ai智算中心全光交换、卫星互联网、量子互联网和产线自动化测试等应用场景。

h s polatis 6000/7000系列全光交换机

关键字: 软件

光纤在线公众号

更多猛料!欢迎扫描左方二维码关注光纤在线官方微信更多关于 软件 的新闻

- (11-30)

- 人工智能驱动的光学i/o发展趋势、核心技术和设计工具 (11-30)

- (11-09)

- (11-06)

- (10-31)

- (07-06)

- (05-24)

- 逍遥科技出席中国光谷九峰山论坛暨化合物半导体产业大会 (04-24)

- (04-07)

- (03-16)